技术突破:从“模仿现实”到“创造规律”

万相2.1的革命性进展,首先体现在其对物理世界的深度建模能力。与传统视频生成模型依赖已有素材的简单拼贴不同,万相2.1采用了自主研发的因果3D VAE架构和DiT(Diffusion Transformer)技术,首次实现了对重力、流体力学等复杂物理规律的精准模拟。例如,在官方Demo中展示的熊猫滑板场景,动物肢体运动与滑板轨迹的互动完全遵循动力学原理,甚至细致地展现了墨汁晕染时表面张力的微妙变化。

更为惊人的是,万相2.1支持无限时长的1080P视频生成。借助创新的特征缓存机制和线性噪声轨迹Flow Matching范式,该模型在单块A800显卡上的重建速度比行业最优方案提升了2.5倍,同时显存占用减少了29%。这意味着,过去需要专业团队花费数月才能完成的影视级特效,如今仅需消费级显卡即可实现实时生成,大大降低了高质量视频创作的门槛。

通过这些技术突破,万相2.1不仅超越了传统视频生成的局限,还为创作者提供了前所未有的自由度和创造力,真正实现了从“模仿现实”到“创造规律”的跨越。

硬件革命:用4070显卡撬动好莱坞生产力

如果说技术参数是专业领域的较量,那么万相2.1对硬件门槛的突破则彻底改写了行业的游戏规则。1.3B版本仅需8.2GB显存即可流畅运行480P视频生成,而14B专业版也只需12GB显存的RTX 4070显卡——这一需求仅为同类闭源模型的三分之一。这种“消费级硬件,工业级输出”的特性,使个人创作者首次能够与专业工作室站在同一起跑线上。

在开发者社区中,已经涌现出许多创新案例:有用户利用极速版生成动态水墨书法视频,实现了文字随场景自然变形的效果;还有团队将模型接入游戏引擎,实时生成NPC互动剧情。这种技术普惠直接催生了“个人数字制片厂”的新业态,极大地激发了创作者的潜力和创造力。

通过大幅降低硬件要求,万相2.1不仅让高质量视频生成变得触手可及,还为个人创作者和小型团队打开了通往专业级内容创作的大门,真正实现了技术的民主化和普及化。

文化基因:最懂中国风的AI艺术家

相2.1的独特之处不仅在于其技术突破,更在于其卓越的文化适配性。作为首个深度理解中文语义的视频生成模型,它能够精准解析如“宣纸晕染福字”这样充满东方美学的指令,并在实际应用中展现出色的表现。例如,在春晚舞台设计的《岁月里的花》节目中,其前代模型Wanx-ACE生成的油画风格舞美动态渐变,赢得了广泛赞誉。

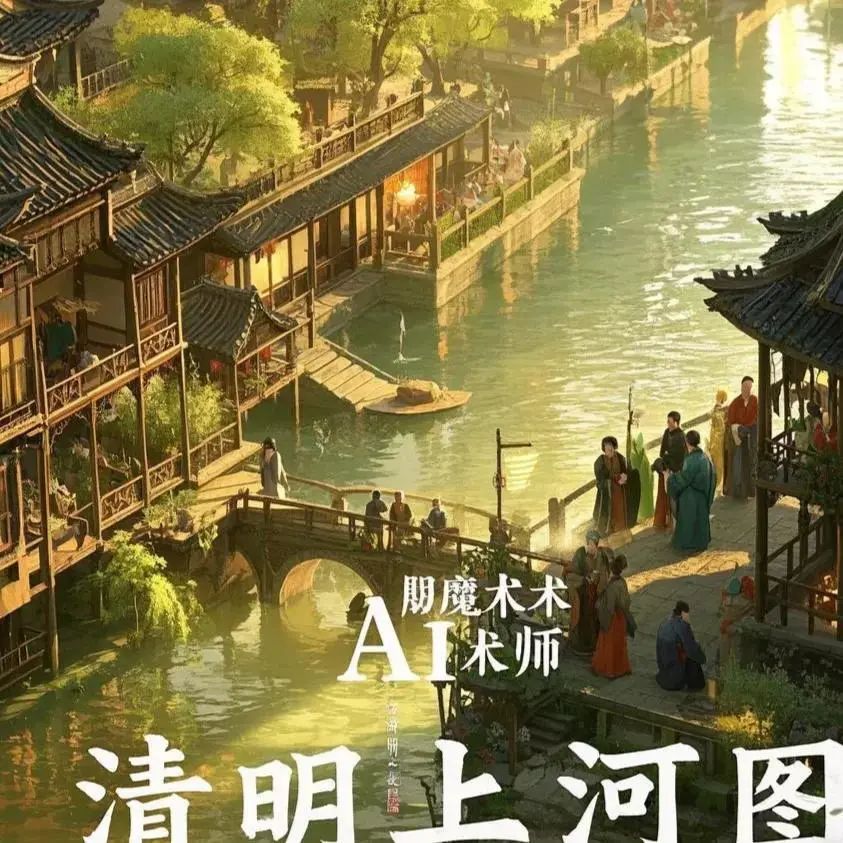

这种文化理解力源自对中文视频语料库的深度挖掘。万相2.1从海量国风影视和水墨动画中提炼出“留白”、“晕染”、“虚实相生”等独特的美学规律,赋予生成视频浓郁的东方艺术气息。当国际模型还在纠结于汉字笔画结构时,万相2.1已经能够自如演绎如《千里江山图》般宏大的空间叙事,展现出中华文化的独特魅力。

开源生态:一场价值3800亿的云端棋局

阿里的开源策略远不止于技术共享。通过Apache 2.0协议开放14B和1.3B双版本模型,其真正的目标是构建一个完整的AI基础设施生态系统。阿里希望通过开源模型吸引开发者完成创意构思,进而引导他们在遇到4K渲染、长视频合成等高级需求时,自然选择阿里云的弹性计算服务。这种“开源铺路,云上变现”的商业模式,与当年Red Hat与IBM的组合有着异曲同工之妙。

数据显示,通义系列开源模型已衍生出超过10万个子模型,形成了全球最大的AI模型家族。万相2.1的开源更是将视频生成领域的开发者全面纳入阿里云的技术版图。配合未来三年3800亿元的AI基础设施投入,阿里正逐步将技术优势转化为定义行业标准的权力。

产业冲击波:谁将被重新定义?